ChatGPT横空出世,GPT4更“聪明”

2022年11月30日,美国人工智能研究公司OpenAI发布人工智能聊天机器人ChatGPT,推出不久便在全球范围内爆火。短短5天,ChatGPT的注册用户数就超过100万,2023年1月末月活用户突破1亿,成为史上增长最快的消费者应用。从用户体验来看, ChatGPT不仅能实现流畅的文字聊天,还可以胜任翻译、作诗、写新闻、做报表、编代码等相对复杂的语言工作。

然而,技术进步是不会停止的。

仅仅过了三个多月,2023年3月15日,OpenAI发布了ChatGPT的最新“升级版本”—— GPT4模型,再次引爆社交媒体。比起ChatGPT,GPT-4拥有更强大的识图能力,文字输入的上限提升到了2.5万字,它能更加流畅准确地回答用户的问题,能写歌词,写创意文本,且风格多变。实验表明,GPT-4在部分专业测试和学术基准上,表现出了与人类相当的水平。

图片来源网络 是的,它变的更加“聪明”了。 不同于以往高高在上的实验室研究成果,这次AI变革的成果正在迅速落地并走向商业化。据路透社报道,OpenAI在2022年的收入预计只有约8000万美元。不过OpenAI表示,到2024年,OpenAI的收入有望提高到10亿美元。红杉资本预测:ChatGPT这类生成式AI工具,让机器开始大规模涉足知识类和创造性工作,未来预计能够产生数万亿美元的经济价值。 在3月21日晚的GTC开发者大会上,NVIDIA创始人兼首席执行官黄仁勋表示,“我们正处于AI的iPhone时刻,”

AIGC商业化撬动万亿AI市场

AIGC(AI Generated Content)即人工智能自动生成内容,可以在创意、表现力、迭代、传播、个性化等方面,充分发挥技术优势,打造新的数字内容生成与交互形态。GPT系列是AIGC的一种商业化方向。 AIGC也被认为是继UGC、PGC/UGC之后的新型内容生产方式。UGC是用户生成内容,起源于Web2.0时代,例如博客、视频分享、Youtube等应用方案;PGC/UGC分别指专业生产内容与职业生成内容,例如视频创收平台优酷、土豆平台节目《暴走漫画》、《万万没想到》、或是抖音、快手等用户生产内容。AIGC在创作成本上具有颠覆性,而且具备降本增效的多重优势,并且有望解决目前PGC/UGC创作质量参差不齐或是降低其有害性内容传播等问题,同时创意激发,提升内容多样性。此外,价格上OpenAI最贵的AIGC语言模型达芬奇为每0.02美元750个单词,AIGC图型模型价格仅为0.020美元一张。 AIGC 应用场景 资料来源: 中国信息通信研究院, 京东探索研究院

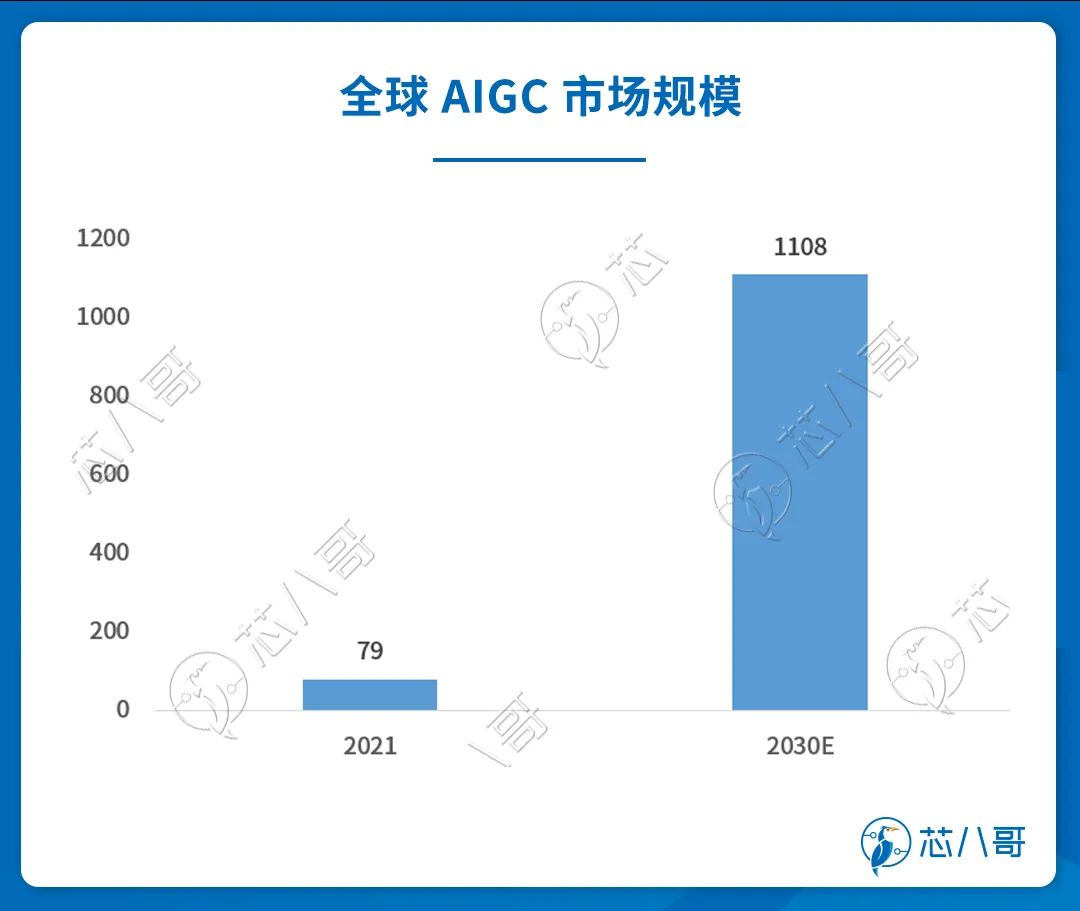

下一代互联网业态对内容产出效率、内容消费的蓬勃需求,将驱动 AIGC 快速发展。结合Gartner 及 Acumen Research and Consulting 预测, 2025 年 AIGC 渗透率将达 10%,至2030 年 AIGC 市场规模达 1108 亿美元 ,对应 2021-2030 年 CAGR 达 34%。其中,对话式AI 预计 2030 年市场规模达 34 亿美元,而2021 年仅为 5.2 亿美元。当前 AIGC 企业变现模式主要为:订阅付费(每月订阅)、按量收费(数据请求量、计算量、图片张数、模型训练次数等),未来 MaaS(模型即服务)有望复制 SaaS 企服路线迎来需求爆发奇点 。 数据来源:Acumen Research and Consulting

群雄逐鹿,中美AI模型军备竞赛正在升级

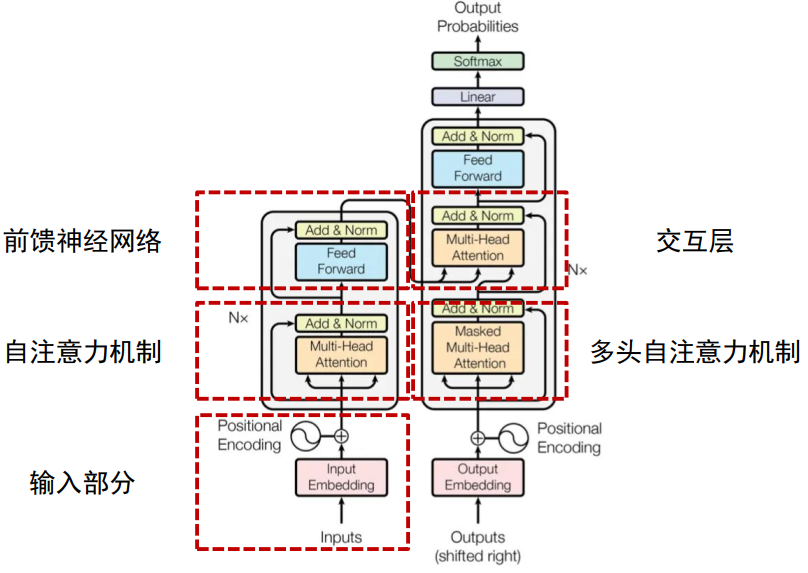

AIGC的发展离不开AI 模型。AI 模型最初是针对特定应用场景需求进行训练(即小模型)。小模型的通用性差,换到另一个应用场景中可能并不适用,需要重新训练,这牵涉到很多调参、调优的工作及成本。同时,由于模型训练需要大规模的标注数据,在某些应用场景的数据量少,训练出来的模型精度不理想的情况,这使得 AI 研发成本高,效率低的情况。 直到2017 年,由Google Brain 团队推出深度学习模型Transformer,采用自注意力机制, 对输入数据的每一部分的重要性进行差异加权,主要用于自然语言处理(NLP) 和计算机视觉(CV)领域。目前,基于Transformer的预训练语言模型已成为NLP领域的主流。ChatGPT是一个出色的NLP新模型。 Transformer的Encoder-Decoder示意图 资料来源:《Attention is All You Need》(Google)

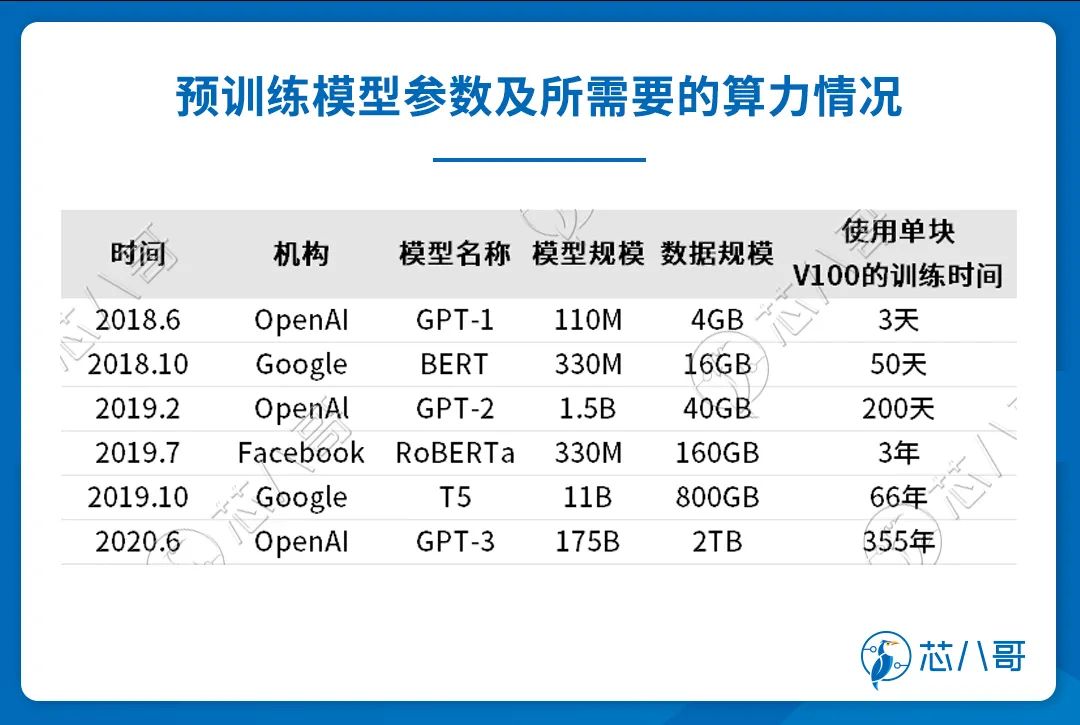

众所周知,GPT-4是一个多模态大模型,那到底什么是多模态呢? 模态是一种社会性、文化性的资源,是物质媒体经过时间塑造而形成的意义潜势。从社会符号学的角度上对模态的认知可以是声音、文字和图像等。人类通过眼睛、耳朵、触觉等各种感觉器官接触世界,每种信息的来源或形式都可以称之为模态。同时,模态也可以是与人类通过自身的感觉器官从外部得到的信息,比如说嗅觉、视觉、听觉等。随着人工智能领域机器学习、深度学习的不断发展,研究内容的不断增加和更新,逐渐也赋予了模态新的定义,即机器对包含数据表征模式、数据收集模式、数据特征主体这3个外部信息的感知模式或信息信道。 多模态机器学习(MultiModal Machine Learning, MMML)研究包含不同模态数据的机器学习问题,一般的模态有视觉、文字和声音。它们通常来自不同的传感器,数据的形成方式和内部结构有很大的不同。例如,图像是存在于自然界中的连续空间,文本是依赖于人类知识、语法规则而组织起来的离散空间。多模态机器学习是指通过机器学习的方法实现处理、理解及融合多源模态信息的能力。目前比较热门的研究方向是文本-图像的模型及应用。 随着ChatGPT的爆火以及多模态大模型GPT-4的推出,中美AI模型军备竞赛正在升级。 美国凭借在模型迭代和算力上的先发优势,聚焦大模型 API 的基础设施层开发,带动信息产业和科学行业发展,并加速商业化。中国公司在 AI 数据及大模型参数量层面与美国差距较小,但模型迭代和训练仍有较大提升空间,大部分平台更加聚焦 AIGC 内容和应用端。 美国主要大模型包括 OpenAI 的 GPT-3、 Anthropic 的 Claude、英伟达与微软的 Megatron Turing-NLG 以及 Meta 的 OPT 等。其中,OpenAI 已经上线了 GPT-4,据传参数量将达到万亿级。Google 把 GPT 系列模型作为红线,并全力投入 LLM(大语言模型)模型的构建。 中国大模型主要包括百度文心、华为盘古、阿里通义、腾讯混云以及商汤的视觉模型等。百度推出文心大模型,基本实现跨模态和多下游多领域的应用,目前已上线文心一言。华为通过模型泛化,解决传统AI 作坊式开放模式下不能解决的 AI 规模化和产业化难题。 资料来源:各公司官网,芯八哥整理 整体来看,美国在模型上仍具有先发优势,源于长时间的技术迭代和数据累积。从 2018 年发布 GPT 1.0,到 2021 年发布 GPT-3.5 和 Instruct GPT, OpenAI 已形成了一系列海量数据积累和训练模型,2023年3月发布的GPT-4 版本(据传万亿级参数量)。虽然当前部分中国大模型参数量能达到千亿级乃至万亿级,但数据质量及训练模型尚需时间精进。

半导体产业机会:GPU主导千亿AI芯片市场

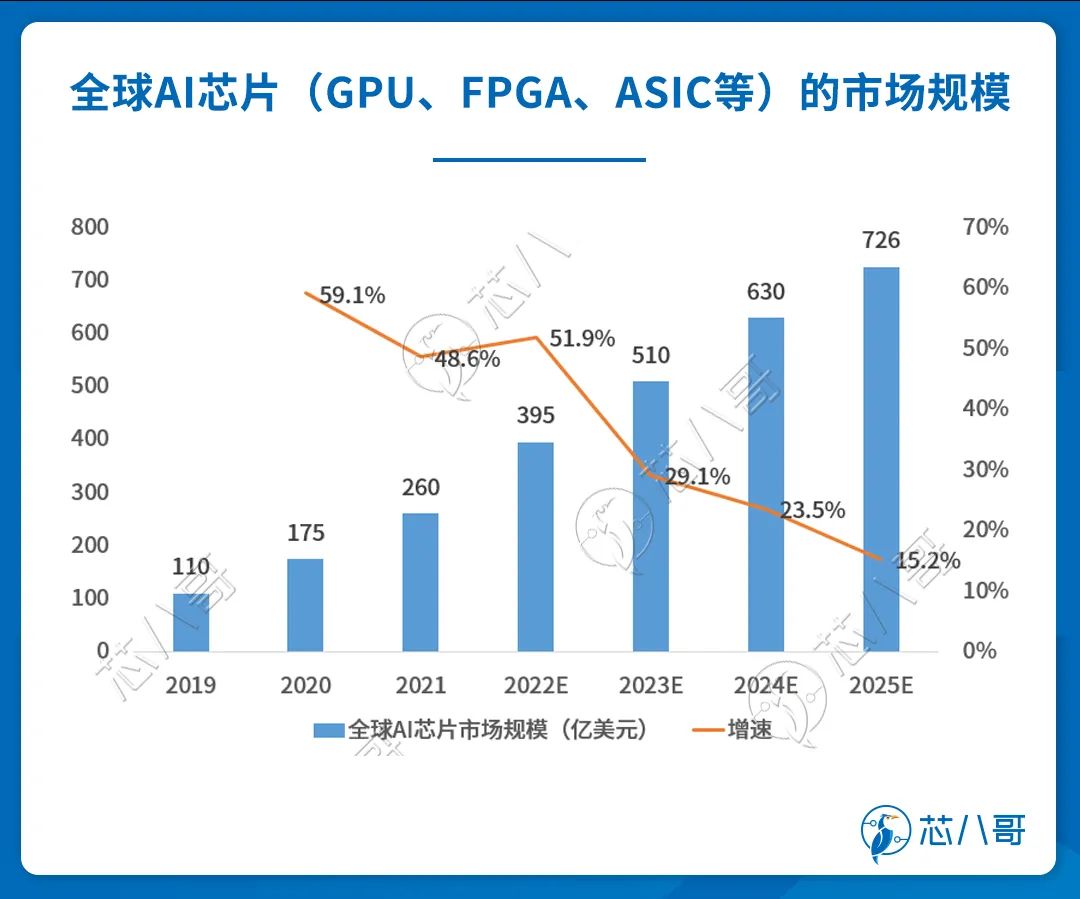

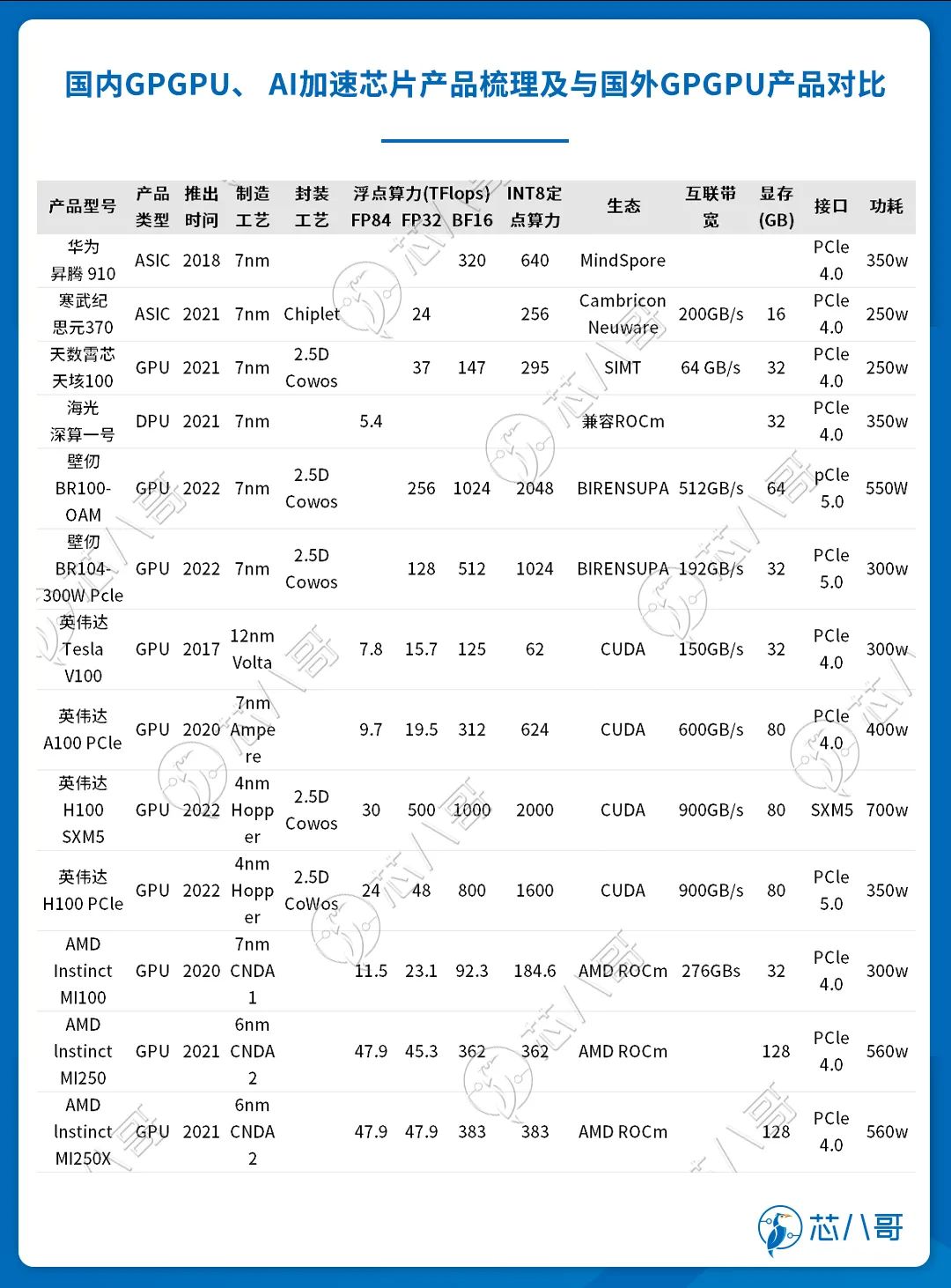

OpenAI预计人工智能科学研究要想取得突破,所需要消耗的计算资源每3~4个月就要翻一倍,资金也需要通过指数级增长获得匹配。在算力方面,GPT-3.5在微软Azure AI超算基础设施(由V100GPU组成的高带宽集群)上进行训练,总算力消耗约 3640PF-days(即每秒一千万亿次计算,运行3640天)。在大数据方面,GPT-2用于训练的数据取自于Reddit上高赞的文章,数据集共有约800万篇文章,累计体积约40G;GPT-3模型的神经网络是在超过45TB的文本上进行训练的,数据相当于整个维基百科英文版的160倍。按照量子位给出的数据,将一个大型语言模型(LLM)训练到GPT-3级的成本高达460万美元。 最新的GPT3.5在训练中使用了微软专门建设的AI计算系统,由1万个英伟达V100 GPU组成的高性能网络集群,总算力消耗约3640PFdays(PD) , 即假如每秒计算一千万亿(1020) 次,需要计算3640天。采购一片英伟达顶级GPU成本为8万元,GPU服务器成本通常超过40万元。对于ChatGPT而言,支撑其算力基础设施至少需要上万颗英伟达GPU A100,一次模型训练成本超过1200万美元。 数据来源:根据公开资料,芯八哥整理 伴随着人工智能应用场景的多元化,新算法、新模型不断涌现,模型中的参数数量呈指数级增长,对算力的需求越来越大。AI芯片是AI算力的“心脏”。根据WSTS数据,2020年全球人工智能芯片市场规模约为175亿美元。随着人工智能技术日趋成熟,数字化基础设施不断完善,人工智能商业化应用将加落地,推动AI芯片市场高速增长,预计2025年全球人工智能芯片市场规模将达到726亿美元。 数据来源:WSTS AI 芯片主要分为三种,分别是 GPU, FPGA 与 ASIC 芯片。不同种类别的 AI 计算芯片有各自突出的优势和适用的领域,贯穿 AI 训练与推理阶段。目前 CPU 在人工智能领域中的应用有限,主要受限于 CPU 在 AI 训练方面的计算能力不足。 资料来源:各公司官网,芯八哥整理 目前来看,GPU 仍然是 AI 应用的主导芯片,主要因为它具有强大的计算能力和高通用适用性,广泛应用于各种图形处理、数值模拟及人工智能算法领域。较低的开发成本也时期能够快速在各个垂直下游领域被广泛应用,加速优化拓展。 在独立 GPU 领域,英伟达占据主导地位,份额高达88% 。英伟达 GPU 因其高性能和对 CUDA 的支持而广泛应用于 AI和机器学习领域。因此, OpenAI 主要使用英伟达GPU来训练和运行其 AI 模型,如 GPT-3 和 ChatGPT。据公开数据显示, ChatGPT 已导入至少 1 万个英伟达高端 GPU。 数据来源:JPR 国内 GPU 主要上市公司中,景嘉微通过自主研发 GPU 并规模化商用,是国内显示控制市场龙头企业。此外,海光信息、寒武纪等公司均有布局 GPU 产品。受美国对中国 GPU 芯片出口管制影响,预计国产 GPU 芯片替代将快速推进。 在加速计算GPU领域,国内壁仞科技发布的BR100产品,在FP32单精度计算性能实现超越NVIDIA A100芯片,但是不支持FP64双精度计算;天数智芯推出的天垓100的FP32单精度计算性能实现超越A100芯片,但是在INT8整数计算性能方面却低于A100;海光推出的DCU Z100实现了FP64双精度浮点计算,但是其性能为A100的60%左右。因此,从高精度浮点计算能力来看,国内GPU产品与国外产品的计算性能仍或有一代以上差距。 但是,GPU的表现不仅体现在硬件上,软件层面对于生态的布局尤其重要,目前国内企业多采用OpenCL进行自主生态建设,但这是需要大量的时间进行。对比AMD从2013年开始建设GPU生态近10年时间后才推出用于通用计算的ROCm开放式软件平台,国内厂商在软件和生态层面与英伟达CUDA生态的差距相较于硬件更为明显。 数据来源:各公司官网

全球AI计算平台巨头的产品布局

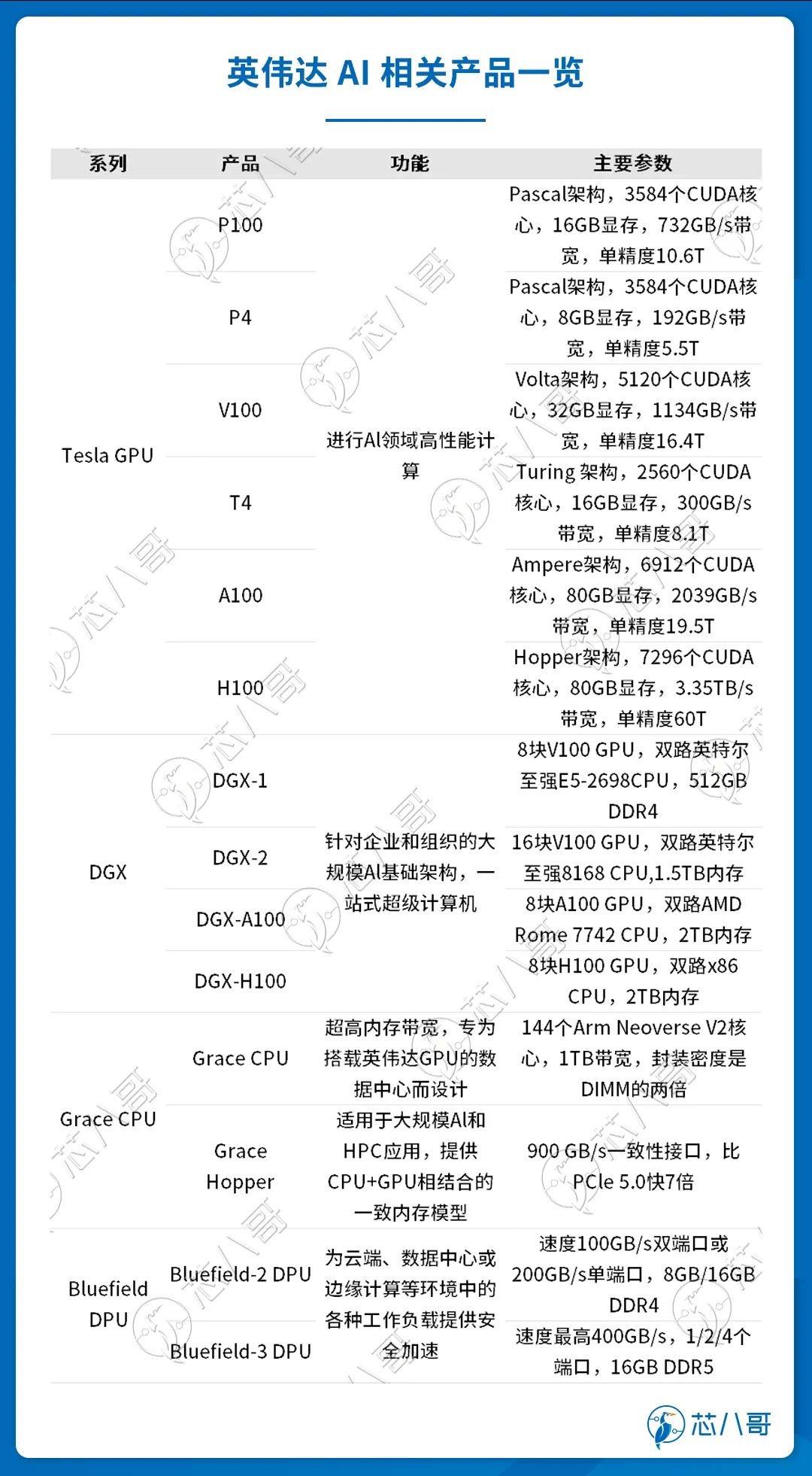

英伟达目前是全球 AI 计算平台龙头,产品矩阵包含硬件、系统软件、平台软件和应用四层。硬件方面,最底层基于 CPU、 GPU、 DPU 三类芯片,形成三大算力支柱;系统层面,从云端到边缘部署广泛的多种系统,如 RTX(云端游戏服务器)、DGX(一站式 AI 解决方案)、HGX(AI 超级计算平台)、EGX(边缘AI 计算平台)、OVX(数字孪生模拟)等,为开发者提供硬件基础设施。平台软件层面,英伟达为开发者提供 150 个加速库服务,涉及机器学习、神经网络、计算机视觉、 基因检测等细分技术领域。应用方面,英伟达打造了一系列针对特定领域的 AI 应用框架,如MODULUS(物理机器学习框架)、RIVA (语音 AI 应用)、 Isaac(机器人平台)等,这些框架都基于 NVIDIA HPC、 NVIDIA AI 和 NVIDIA Omniverse 平台构建。每一层级都对计算机制造商、服务提供商和开发者开放,软硬一体的解决方案适用于广泛下游领域。 英伟达基于 GPU、 DPU 和 CPU 构建加速计算平台生态,造就核心技术壁垒。 英伟达产品规划图 资料来源:英伟达官网

GPU方面,主要产品 Tesla GPU 系列迭代速度快,从 2008 年至 2022 年,先后推出 8 种 GPU 架构,平均两年多推出新架构,半年推出新产品。超快的迭代速度使英伟达的 GPU 性能走在 AI 芯片行业前沿,引领人工智能计算领域发生变革。 DPU 方面,英伟达于2019年战略性收购以色列超算以太网公司 Mellanox,利用其InfiniBand(无限带宽)技术设计出 Bluefield 系列 DPU 芯片,弥补其生态在数据交互方面的不足。InfiniBand 与以太网相同,是一种计算机网络通信标准,但它具有极高的吞吐量和极低的延迟,通常用于超级计算机的互联。英伟达的 Bluefield DPU 芯片可用于分担 CPU 的网络连接算力需求,从而提高云数据中心的效率,降低运营成本。 CPU 方面,自主设计 Grace CPU 并推出 Grace Hopper 超级芯片,解决内存带宽瓶颈问题。采用 x86 CPU 的传统数据中心会受到 PCIe 总线规格的限制,CPU 到 GPU 的带宽较小,计算效率受到影响;而 Grace Hopper 超级芯片提供自研 Grace CPU+GPU 相结合的一致内存模型,从而可以使用英伟达 NVLink-C2C 技术快速传输,其带宽是第 5 代 PCIe 带宽的 7 倍,极大提高了数据中心的运行性能。 资料来源:英伟达官网 英伟达 GPU 因其高性能和对 CUDA 支持而广泛应用于 AI 和机器学习领域。OpenAI 主要使用英伟达 GPU 来训练和运行 AI 模型,如 GPT-3 和 ChatGPT。据公开数据显示, ChatGPT 已导入至少1万个英伟达NVIDIA A100。作为Ampere架构首发的NVIDIA A100,相较Tesla V100 可提高2.5 倍HPC 运算量,单片A100单价约为8万元人民币。 H100 所结合的技术创新,可加速大型语言模型速度,比A100快30 倍,提供领先业界的对话式人工智能加速(类似ChatGPT)。H100于2022年3月22日推出, 配备了 80 GB 显存,搭载 NVIDIA Hopper HPC GPU,采用台积电4nm制程,单价超过20万元。H100 配备第四代Tensor核心和具有FP8精确度的Transformer Engine,能够依据动态管理与选择FP8与FP16,并自处理模型每一层FP8与FP16的自动转换,相对现行的A100架构,能使AI训练提升9倍、并使推理能提升30倍,同时不影响精确性。 目前华硕、源讯、戴尔、INGRASYS、技嘉、联想与美超微( Supermicro)等NVIDIA的众多合作伙伴推出搭载A100/H100产品,已在AWS、Google Cloud、Microsoft Azure 及 Oracle Cloud Infrastructure等各大云端平台上使用。